ملف robots.txt ووردبريس واحد من أهم الملحقات التقنية لمواقع الويب التي يجهل الكثيرون أهميتها في أرشفة المواقع وتحسين نتائج الـ SEO. خطأ بسيط في هذا الملف قد يؤدي إلى انخفاض معدل الزوار لديك الواردين من مواقع البحث، وعدم اهتمامك به قد يتسبب في زيادة الضغط على سيرفر موقعك، كذلك قد يعرضك لمشاكل تخص السيو؛ لذلك أنت بحاجة لمعرفة استخدامه بالشكل الصحيح حتى تدفع موقعك نحو نتائج أعلى تصنيفًا.

كيف تعمل عناكب محركات البحث

قبل التطرق إلى ماهية ملف robots.txt ووردبريس يجب أولًا أن نوضح كيفية عمل عناكب المحركات البحثية أثناء الترتيب، وبعدها مباشرة نشرح كل ما يتعلق بملف الروبوت؛ وذلك لأن الأمر المقترن بينهما أن هذا الملف يعمل مباشرة مع (العناكب البحثية).

عناكب وروبوتات تبحث وتجمع وتصنف

أي محرك بحث لديه عناكب أو روبوتات تتنقل باستمرار على الإنترنت للعثور على المعلومات ووضعها في فهرس / قاعدة بيانات مخصصة لذلك لدى هذا المحرك. هذه العناكب تنتقل عبر الروابط، وتستوعب المعلومات التي تجدها في الصفحة بشرط أن المعلومات مقدمة لها بتنسيق مناسب. لذلك يجب أن يكون ضمان قدرتهم على الوصول إلى كل المحتوى وقراءته من داخل المواقع جزءًا أساسيًا من أي استراتيجية لتحسين السيو.

العناكب تبحث عن ملف robots.txt

عندما يصل عنكبوت الـ Search Engine إلى موقعك أو المتجر الخاص بك، فإن أول شيء يفعله أنه يتأكد من وجود ملف robots.txt لديك؛ لأن هذا الملف يعطي الأوامر للعناكب ويوضح لهم أي الأجزاء من الموقع مسموح الزحف إليها، وأيها ممنوع عليهم الزحف.

لماذا تفعل العناكب ذلك؟

لأنه في عام 1994، تم نشر بروتوكول يسمى REP (بروتوكول استبعاد الروبوتات القياسي) الذي ينص على أنه يجب على جميع برامج الزحف لمحركات البحث (وكلاء المستخدم) أن تبحث أولاً عن ملف robots.txt في الدليل الجذر لموقعك وقراءة الإرشادات التي يحتوي عليها. وعندها فقط، يمكن أن تبدأ الروبوتات في فهرسة صفحتك.

لسوء الحظ، لا تتبع كل الروبوتات هذه القواعد، ولكن على الأقل تلتزم أهم محركات بحث مثل Bing وYahoo وGoogle بهذه التعليمات بدقة.

مهمة العناكب والروبتات داخل الموقع

فور ذلك تبدأ الروبوتات في الزحف لموقعك لتخزين المعلومات، وجميع الروابط التي يجدونها لديك، ويقومون بتتبع كافة الروابط في مهمة مستمرة لا تنقطع. وللعلم فقد كان المفهوم الأصلي وراء شبكة الإنترنت هو أن كل شيء يتم ربطه معًا بشكل متسلسل. لا يزال هذا المبدأ جزءًا أساسيًا من الفهرسة وهو كيفية تنقل الروبوتات ضمن الشبكة وفهرستها للمواقع.

مثال: فهرس جوجل

يتم تجميع كافة البيانات التي جمعتها عناكب جوجل في فهرس جوجل Google Index، ومن ثم يتم ترتيب الصفحة وفقًا للقواعد والخوارزميات المستخدمة في التقييم. لتظهر فيما بعد للمستخدم عند إدخال الاستعلامات في مربع بحث جوجل مثلا.

ما هو ملف robots.txt

إذن من الخطوات السابقة نعرف أن ملف robots.txt المعروف كذلك باسم بروتوكول استبعاد الروبوتات، هو عبارة عن ملف تتفحصه العناكب حتى تتمكن من فهرسة الموقع وفق الإرشادات المذكورة فيه.

مثلا إذا كانت لديك صفحات أو أقسام معينة لا تريد من عناكب المحركات البحثية مشاهدتها، فيمكنك حظر التوجه إليها عبر تضمين أوامر خاصة بحظر الفهرسة.

عن طريق إدارة هذا الملف بشكل جيد، ستتمكن من تحديد الأمور التي ستتم فهرستها من طرف العناكب، وستتمكن أيضا من تحديد الأمور التي لا تريد من عناكب محركات البحث فهرستها.

الاستخدامات

بصفتك مسؤول عن استخدام الملف بشكل صحيح؛ فمن الناحية العملية، يمكن استخدام ملف robots.txt مع أنواع مختلفة من البيانات، مثلا يمكنك استبعاد الصفحات التي تم إنشاؤها ديناميكيًا من الزحف باستخدام الأوامر (dynamics pages)، نقصد على سبيل المثال: صفحات البحث الداخلي أو الصفحات التي تحتوي على معرّفات الجلسات أو إجراءات المستخدم مثل عربات التسوق.

يمكنك أيضًا التحكم في وصول الزاحف إلى أي ملفات على موقعك بالطريقة التي تراها مناسبة، وبالتالي تتجنب الأمور التالية:

- قيام روبوتات البحث بالزحف إلى الكثير من الصفحات المتشابهة أو غير المهمة؛ مما يتسبب في إهدار ميزانية الزحف الخاصة بك دون داع.

- تحميل خادمك بشكل زائد عن طريق برامج الزحف.

الإيجابيات

إدارة ميزانية الزحف

من المفهوم بشكل عام أن عنكبوت البحث يصل إلى موقع ويب مع عدد محدد مسبقًا للصفحات التي سيزحف إليها (أو مقدار الموارد/الوقت الذي سيقضيه، بناءً على سلطة الموقع/حجمه/سمعته، ومدى كفاءة استجابة الخادم). تسمي مُحسّنات محرّكات البحث هذه ميزانية الزحف.

إذا كنت تعتقد أن موقعك لديه مشاكل مع ميزانية الزحف، فإن الحل المحتمل هو منع محركات البحث من إهدار الطاقة في أجزاء غير مهمة والتركيز بدلاً من ذلك على الأقسام المهمة.

منع أرشفة الأقسام التي بها مشاكل

قد يكون من المفيد في بعض الأحيان منع محركات البحث من الزحف إلى الأقسام التي بها مشكلات لديك، خاصةً في المواقع التي يجب إجراء الكثير من عمليات تنظيف تحسين محركات البحث فيها. بمجرد الانتهاء من ترتيب الأمور، يمكنك السماح لها بالدخول مرة أخرى.

السلبيات

عدم إزالة صفحة من نتائج البحث

على الرغم من أنه يمكنك استخدام ملف robots.txt لإخبار العنكبوت بالمكان الذي لا يمكنه الوصول إليه، لكن لا يمكنك استخدامه لإخبار محرك البحث بعناوين URL التي لا يجب عرضها في نتائج البحث - بمعنى آخر، الحظر لن يمنعه من الفهرسة.

إذا كنت تريد منع صفحة ما بشكل موثوق من الظهور في نتائج البحث، فأنت بحاجة إلى استخدام علامة noindex الوصفية لبرامج الروبوت. وهذا يعني أنه للعثور على علامة noindex، يجب أن يكون محرك البحث قادرًا على الوصول إلى تلك الصفحة، لذلك لا تحظرها باستخدام ملف robots.txt.

عدم انتشار قيمة الارتباط

إذا لم يتمكن محرك البحث من الزحف إلى صفحة، فلا يمكنه نشر قيمة الرابط عبر الروابط الموجودة في تلك الصفحة. عندما يتم حظر صفحة باستخدام ملف robots.txt، فإن ذلك يمثل طريقًا مسدودًا. يتم فقد أي قيمة ارتباط قد تتدفق إلى (وعبر) تلك الصفحة.

تأثير ملف robots.txt على SEO

التعليمات الموجودة في ملف robots.txt لها تأثير قوي على SEO (تحسين محركات البحث) حيث يسمح لك الملف بالتحكم في روبوتات البحث. ومع ذلك، إذا تم تقييد وكلاء المستخدم كثيرًا من خلال تعليمات عدم السماح، فسيكون لذلك تأثير سلبي على ترتيب موقع الويب الخاص بك.

يجب أيضًا أن تضع في اعتبارك أنك لن تقوم بالترتيب مع صفحات الويب التي استبعدتها عن طريق عدم السماح في ملف robots.txt. من ناحية أخرى، إذا لم تكن هناك قيود أو بالكاد تمنع أي قيود، فقد يحدث أن تتم فهرسة الصفحات ذات المحتوى المكرر، مما يؤثر أيضًا بشكل سلبي على ترتيب هذه الصفحات.

قبل حفظ الملف في الدليل الجذر لموقع الويب الخاص بك، يجب عليك التحقق من بناء الجملة؛ لأن الأخطاء الطفيفة في هذا الملف يمكن أن تؤدي إلى مشاكل في الفهرسة، أي قد تتجاهل قواعد عدم السماح والزحف إلى مواقع الويب التي لا ينبغي فهرستها أو العكس.

يمكن أن تؤدي هذه الأخطاء أيضًا إلى عدم إمكانية الوصول إلى الصفحات من قبل روبوتات البحث وعدم فهرسة عناوين URL بالكامل بسبب عدم السماح بذلك. يمكنك التحقق من صحة ملف robots.txt الخاص بك باستخدام Google Search Console.

باستخدام ملف robots.txt وورد بريس بشكل صحيح، يمكنك التأكد من الزحف إلى جميع الأجزاء المهمة من موقع الويب الخاص بك بواسطة روبوتات البحث. وبالتالي، تتم فهرسة محتوى صفحتك بالكامل بواسطة Google ومحركات البحث الأخرى.

إنشاء ملف robots.txt بالتفصيل للمبتدئين

وسنميز في هذه الفقرات بين إنشاء ملف robots.txt بالتفصيل للمبتدئين وإنشاء وتعديل ملف robots.txt عن طريق Yoast SEO وعن طريق Rank Math SEO أيضا.

إنشاء ملف robots.txt بالتفصيل للمبتدئين بشكل يدوي

1. قم بإنشاء ملف Robots.txt

- قم بإنشاء ملف جديد في bloc-notes أو في أي محرر نصوص آخر وقم بتسميته robots.txt واحفظه في جهازك.

- ستحتاج إلى التأكد من أن ملف robots.txt الخاص بك هو ملف نصي بترميز UTF-8. قد تتجاهل Google ومحركات البحث وبرامج الزحف الشائعة الأخرى أحرفًا خارج نطاق UTF-8، مما قد يجعل قواعد ملف robots.txt الخاصة بك غير صالحة.

- تأكد من وضع ملف robots.txt مباشرة في الدليل الجذر لنطاقك ويجب كتابته بأحرف صغيرة لأن الروبوتات حساسة لحالة الأحرف.

أهم جزء في الملف هو إنشائه وموقعه. ويمكن العثور عليه في:

- جذر المجال الخاص بك: www.yourdomain.com/robots.txt

- نطاقاتك الفرعية: page.yourdomain.com/robots.txt

- المنافذ غير القياسية: www.yourdomain.com:881/robots.txt

ملحوظة: لا يتم وضع ملفات Robots.txt في تصنيف فرعي للمجال الخاص بك (www.yourdomain.com/page/robots.txt).

2. حدد وكيل مستخدم ملف Robots.txt الخاص بك

يتعلق وكيل المستخدم ببرامج زحف الويب أو محركات البحث التي ترغب في السماح بها أو حظرها. يمكن أن تكون عدة كيانات وكيل المستخدم. لقد قمنا بإدراج بعض برامج الزحف أدناه، بالإضافة إلى ارتباطاتها.

هناك ثلاث طرق مختلفة لإنشاء وكيل مستخدم داخل ملف robots.txt الخاص بك.

1 - إنشاء وكيل مستخدم واحد

الصيغة التي تستخدمها لتعيين وكيل المستخدم هي:

User-agent: NameOfBotمع تغيير NameOfBot إلى اسم الوكيل المستخدم. DuckDuckBot هو وكيل المستخدم الوحيد الذي تم إنشاؤه.

User-agent: DuckDuckBot2 - إنشاء أكثر من وكيل مستخدم واحد

إذا كان علينا إضافة أكثر من واحد، فاتبع نفس العملية كما فعلت مع وكيل مستخدم DuckDuckBot في الفقرة السابقة بإدخال اسم وكيل المستخدم الإضافي. في هذا المثال، استخدمنا Facebot.

- مثال على كيفية تعيين أكثر من وكيل مستخدم

User-agent: DuckDuckBot

User-agent: Facebot3 - تعيين جميع برامج الزحف كوكيل المستخدم

علامة النجمة (*) تعني الكل، وبعد كتابتها تقرر إذا أردت حظر / السماح للكل، وهذا مثال على كيفية تعيين جميع برامج الزحف كوكيل مستخدم

User-agent: *3. تعيين القواعد لملف Robots.txt الخاص بك

تتم قراءة ملف robots.txt في مجموعة أوامر. ستحدد المجموعة من هو وكيل المستخدم ولديها قاعدة أو توجيه واحد للإشارة إلى الملفات أو الدلائل التي يمكن لوكيل المستخدم الوصول إليها أو لا يمكنه الوصول إليها. وفيما يلي التعليمات المستخدمة:

Disallow: الأمر الذي يشير إلى صفحة أو دليل متعلق بنطاقك الأساسي لا تريد أن يزحف إليه وكيل المستخدم المحدد. سيبدأ بشرطة مائلة للأمام (/) متبوعة بعنوان url للصفحة الكاملة. ستنهيها بشرطة مائلة للأمام فقط إذا كانت تشير إلى دليل وليس إلى صفحة كاملة. يمكنك استخدام إعداد واحد أو أكثر من إعدادات عدم السماح لكل قاعدة.

Allow: يشير الأمر إلى صفحة أو دليل متعلق بنطاقك الجذر الذي تريد أن يزحف إليه وكيل المستخدم المحدد. على سبيل المثال، يمكنك استخدام الأمر allow لتجاوز قاعدة عدم السماح. سيبدأ أيضًا بشرطة مائلة للأمام (/) متبوعة بعنوان url للصفحة الكاملة. ستنهيها بشرطة مائلة للأمام فقط إذا كانت تشير إلى دليل وليس إلى صفحة كاملة. يمكنك استخدام واحد أو أكثر من إعدادات السماح لكل قاعدة.

Sitemap: توجيه خريطة الموقع اختياري ويعطي موقع خريطة الموقع لموقع الويب. الشرط الوحيد هو أنه يجب أن يكون عنوان URL مؤهلًا بالكامل. يمكنك استخدام صفر أو أكثر، حسب ما هو ضروري.

تعالج برامج زحف الويب المجموعات من أعلى إلى أسفل. كما ذكرنا من قبل، فإنهم يصلون إلى أي صفحة أو دليل لم يتم تعيينه صراحة على عدم السماح. لذلك، أضف Disallow: / أسفل معلومات وكيل المستخدم في كل مجموعة لمنع وكلاء المستخدم المعينين من الزحف إلى الموقع.

مثال على كيفية منع DuckDuckBot

User-agent: DuckDuckBot

Disallow: /- مثال على كيفية حظر أكثر من وكيل مستخدم

User-agent: DuckDuckBot

User-agent: Facebot

Disallow: /- مثال على كيفية منع جميع برامج الزحف

User-agent: *

Disallow: /لحظر نطاق فرعي معين من جميع برامج الزحف، أضف شرطة أمامية مائلة وعنوان URL للنطاق الفرعي الكامل في قاعدة عدم السماح.

User-agent: *

Disallow: /https://page.yourdomain.com/robots.txtإذا كنت ترغب في حظر دليل، فاتبع نفس العملية عن طريق إضافة شرطة مائلة للأمام واسم الدليل الخاص بك، ولكن قم بعد ذلك بشرطة مائلة أخرى.

User-agent: *

Disallow: /images/أخيرًا، إذا كنت ترغب في أن تقوم جميع محركات البحث بجمع المعلومات عن جميع صفحات موقعك، فيمكنك إنشاء قاعدة سماح أو عدم السماح، ولكن تأكد من إضافة شرطة مائلة للأمام عند استخدام قاعدة السماح. يتم عرض أمثلة على كلتا القاعدتين أدناه.

مثال للسماح لجميع برامج الزحف

User-agent: *

Allow: /مثال لعدم السماح لجميع برامج الزحف

User-agent: *

Disallow: /4. قم بتحميل ملف Robots.txt الخاص بك

لا تأتي مواقع الويب تلقائيًا مع ملف robots.txt لأنه غير مطلوب. بمجرد أن تقرر إنشاء ملف، قم بتحميل الملف إلى الدليل الجذر لموقعك على الويب. يعتمد التحميل على بنية ملف موقعك وبيئة استضافة الويب لديك. تواصل مع موفر الاستضافة للحصول على مساعدة حول كيفية تحميل ملف robots.txt وورد بريس الخاص بك.

5. تأكد من أن ملف robots.txt يعمل بشكل جيد

هناك عدة طرق للاختبار والتأكد من أن ملف robots.txt ووردبريس يعمل بشكل صحيح. مع أي واحد من هؤلاء، يمكنك رؤية أي أخطاء في بناء الجملة أو المنطق. فيما يلي عدد قليل منهم:

- أداة اختبار ملف robots.txt من Google في Search Console.

- مدقق robots.txt و TestingTool من شركة Merkle، Inc.

- أداة اختبار ملف robots.txt من Ryte.

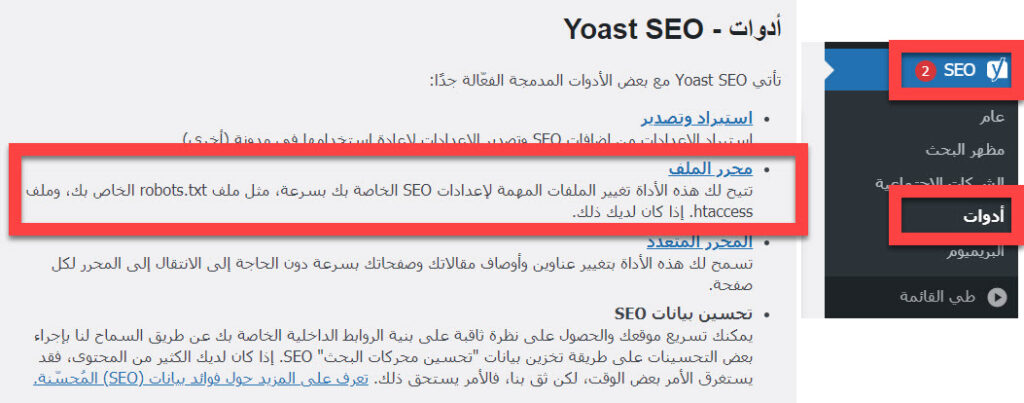

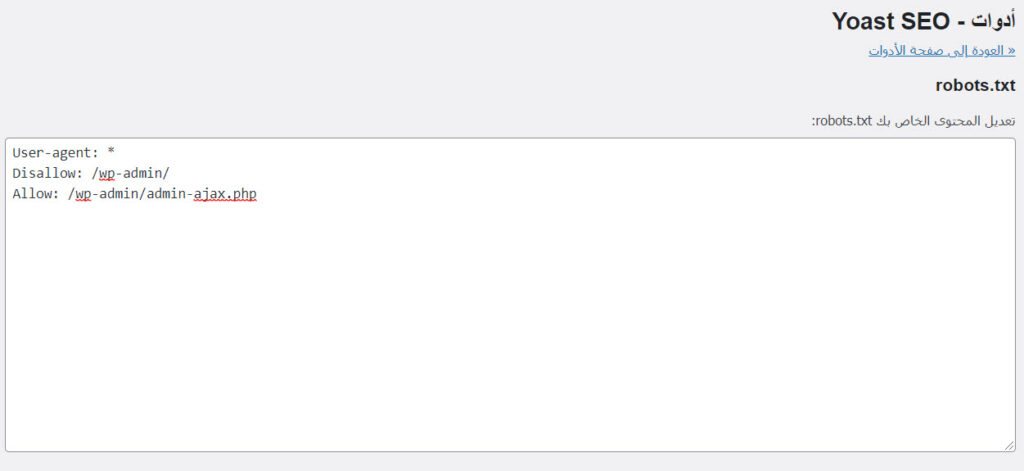

إنشاء أو تعديل ملف robots.txt عن طريق Yoast SEO

إذا كانت لديك إضافة يوست سيو مثبتة على موقعك، فستتمكن من إنشاء أو تعديل ملف robots.txt بكل سهولة وخلال بضع دقائق فقط. والعديد من أصحاب المواقع يعتبرنها أسهل طريقة لإنشاء ملف robots.txt أو تحريره. للقيام بذلك، اتبع الخطوات التالية.

- قم بتسجيل الدخول إلى موقع WordPress الخاص بك.

- انقر فوق "SEO".

- انقر فوق "أدوات".

- انقر فوق "File Editor".

- قم بإجراء التغييرات على ملف robots.txt وورد بريس الخاص بك.

- احفظ التغييرات.

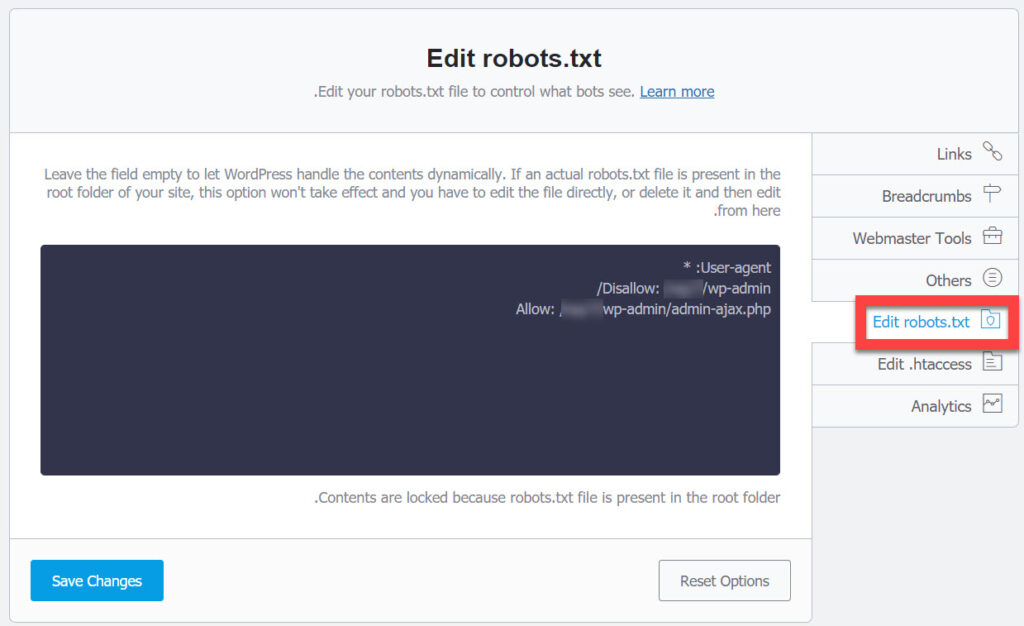

إنشاء أو تعديل ملف robots.txt عن طريق Rank Math SEO

1. انتقل إلى ملف Robots.txt الخاص بك

- قم بتسجيل الدخول إلى موقع WordPress الخاص بك وتأكد من تمكين الوضع المتقدم من لوحة تحكم Rank Math.

- من القائمة الجانبية، توجه إلى خيار "Rank Math"

- بعد ذلك اضغط على خيار "General Settings"

- ستظهر لك قائمة فيها مجموعة من الخيارات وستجد من بينها ملف robots.txt، اضغط عليه

2. قم بالتعديل على ملف Robots.txt

يمكنك كتابة الأوامر التي تريد إضافتها إلى ملف robots.txt في منطقة النص المتاحة. بشكل افتراضي، ستضيف Rank Math رابط ملف Sitemap الخاص بك هنا تلقائيًا، مما يجعلها متاحة للروبوتات للزحف.

3. احفظ التغييرات

احفظ تغييراتك بالنقر فوق حفظ التغييرات بمجرد إجراء التغييرات اللازمة على الملف.

وهكذا نكون أبرزنا لكم أهم ما يجب معرفته عن ملف robots.txt وكيفية تحسين محركات البحث وفقه. وبغض النظر عن تخصيص ملف robots.txt وورد بريس بالشكل الصحيح، إلا أنه يعد جزءا ميسورا من كامل خطوات تصدر نتائج محركات البحث. وإن كان لديكم أي تساؤل أو رأي أو تعقيب بخصوص هذا المقال فسنرحب بآرائكم في خانة التعليقات. ولقاءنا يتجدد مع قادم المقالات بإذن الله.

اترك تعليقك